Insights and perspectives

Les promesses de l’informatique quantique

Peu connue du grand public, l’informatique quantique inaugure une informatique d’un genre nouveau aux promesses vertigineuses : accélération de la découverte de nouveaux matériaux pour l’industrie, de nouvelles molécules actives pour le secteur pharmaceutique, communications et échanges en ligne absolument sécurisés pour les particuliers et les entreprises.

L’amélioration des performances de l’IA et la résolution pratique d’innombrables problèmes d’optimisation combinatoire jusqu’ici hors de portée des plus puissants superordinateurs font également partie des ambitions à portée de l’informatique quantique.

Chacune de ces avancées recèle, pour les industries concernées, des gains potentiels de plusieurs milliards de dollars à moyen terme. L’exemple de l’industrie pharmaceutique est à cet égard particulièrement édifiant. Il faut en moyenne 10 à 15 ans et investir 2,6 milliards de dollars pour découvrir, tester et mettre sur le marché une nouvelle molécule, des sommes considérables qui n’ont cessé de croître sous l’effet de l’allongement de la durée des phases cliniques et de l’essoufflement des méthodes de simulation classiques, confrontées à des architectures moléculaires toujours plus complexes. Si les promesses du calcul quantique se concrétisent, les gains d’efficacité opérationnelle qu’il générera en feront sans doute l’un des principaux relais de croissance du secteur pharmaceutique.

Démystifier le quantique

Le développement de cette informatique nouvelle est le fruit du raffinement des techniques de manipulation d’atomes individuels développées en laboratoire depuis le début des années 1980. Le support physique de l’information sur lequel elle opère, le qubit, joue en informatique quantique le rôle joué par le bit (abréviation couramment utilisée de « binary digit ») de l’informatique conventionnelle. Un calculateur quantique consiste en la donnée d’un ensemble de qubits (on parle de registre) sur lequel agissent des portes logiques, qui jouent quant à elle le rôle dévolu aux transistors. Les percées réalisées en physique expérimentale permettent aujourd’hui de manipuler des registres dont la taille ne cesse de croître.

Cette combinaison de perspectives prometteuses et de progrès d’ingénierie spectaculaires, régulièrement couverts par la presse généraliste, a séduit les investisseurs, attirés par un marché qui devrait représenter 8,6 milliards de dollars à l’horizon 2027 contre 555 millions de dollars en 2021. Pour preuve, après avoir levé 25 millions d’euros en série A en juin 2021, la start-up française Pasqal a réussi une levée de fonds record de 100 millions d’euros le 24 janvier dernier auprès du fonds souverain singapourien Temasek. Pasqal réaffirme son ambition de livrer son premier ordinateur quantique à base d’atomes neutres en 2024.

Comprendre les capacités du calcul quantique nécessite au préalable de dissiper certaines idées erronées dont les médias se font l’écho en raison d’une simplification excessive des idées. La première est de penser que les ordinateurs quantiques viendront se substituer aux ordinateurs actuels. Il est en fait probable qu’ils ne les remplaceront jamais, pour la raison que ces deux technologies possèdent des atouts complémentaires. Là où les machines actuelles sont particulièrement adaptées à la bureautique et ont vu leur prix décroître de façon spectaculaire au cours des dernières décennies grâce à une industrie des semiconducteurs arrivée depuis longtemps à maturité, les calculateurs quantiques seront essentiellement employés par les entreprises pour résoudre des problèmes d’optimisation combinatoire.

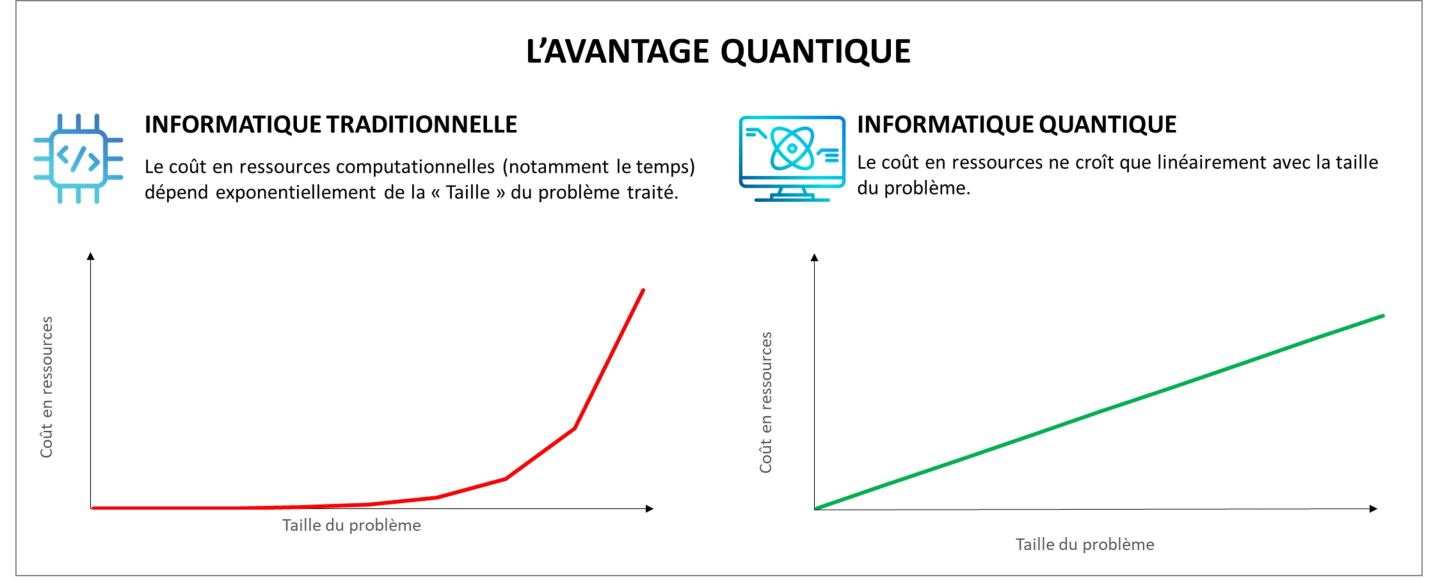

Par ailleurs, l’ordinateur quantique ne calcule pas plus vite que les ordinateurs actuels. En réalité, leurs performances ne seront supérieures à celles des ordinateurs conventionnels que sur un sous-ensemble bien particulier de certains problèmes algorithmiques, que les théoriciens de la complexité appellent les problèmes NP. NP regroupe l’ensemble des problèmes algorithmiques pour lesquels on peut efficacement, c’est-à-dire en un temps qui croît de façon « raisonnable » avec le nombre des variables considérées, vérifier la justesse d’une solution candidate. Un calculateur quantique ne calcule pas plus vite qu’un ordinateur classique, mais il est capable de résoudre efficacement certains problèmes NP pour lesquels il est conjecturé qu’il n’existe pas d’algorithmes de résolution efficaces.

C’est la principale raison derrière l’engouement actuel pour le quantique : pouvoir traiter en un temps raisonnable de nombreux problèmes d’intérêt pour des industries aussi variées que celles des microprocesseurs, de l’énergie et de la finance qui sont fondamentalement hors de portée des techniques actuelles. Le principe qui rend ceci possible tient à une propriété remarquable des systèmes quantiques : la capacité d’encodage de l’information d’un registre double pour chaque qubit ajouté, d’où il résulte un accroissement linéaire des besoins en ressources en fonction de la taille du problème considéré. À titre de comparaison, la résolution de certains problèmes NP en un temps comparable requiert un accroissement exponentiel du nombre de transistors. C’est cette différence fondamentale qui permet d’affirmer que l’ordinateur quantique devrait un jour dépasser les ordinateurs à architecture classique dans la résolution de certains problèmes. Cette attente porte d’ailleurs un nom : la suprématie ou avantage quantique, c’est-à-dire la supériorité indiscutable sur l’informatique conventionnelle pour certaines applications pratiques.

La cryptographie RSA mise en péril par l’informatique quantique

Ainsi, à titre d’exemple, les progrès de l’informatique quantique menace d’obsolescence le système de cryptographie RSA aujourd’hui omniprésent. C’est ce protocole qui garantit la sécurité des transactions sur internet. Il consiste en la donnée de deux clés. L’une, appelée clé publique, est un très grand nombre entier, dont la taille en base binaire varie généralement entre 1024 et 4096 chiffres. La clé privée est un nombre entier diviseur de la clé publique, que l’utilisateur est le seul à posséder.

La difficulté qu’ont les ordinateurs à factoriser de très grands nombres est au cœur de la fiabilité du protocole. Si quelques heures suffisent en général à casser une clé publique à 300 chiffres, le temps estimé pour une clé à 4096 chiffres est de 300 trillions d’années. Le problème de la factorisation est un exemple de problème NP : vérifier une solution candidate revient à effectuer une très longue division. Mais déterminer un diviseur de grande taille requiert des ressources qui croissent exponentiellement avec la taille de la clé publique. L’algorithme de Shor, qui est resté célèbre comme l’une des premières applications intéressantes de l’ordinateur quantique, permet de résoudre efficacement le problème de la factorisation. Les protocoles cryptographiques qui garantissent aujourd’hui la sécurité des paiements en ligne sont d’ores et déjà marqués du sceau de l’obsolescence et une véritable course à la cryptographie post-quantique a déjà démarré.

Des opportunités et des risques pour les entreprises

L’enjeu du quantique pour les entreprises, et plus particulièrement pour le secteur bancaire, est double : améliorer l’efficacité opérationnelle des activités existantes - voire en développer de nouvelles — et ne pas manquer le virage technologique au risque d’être déclassé, faute d’avoir adopté à temps une technologie devenue indispensable.

En supposant que cette technologie se révèle un jour à la hauteur des espoirs placés en elle, et qu’une des approches actuellement en concurrence n’atteigne le seuil critique auquel se manifeste la suprématie quantique, l’intérêt se porte sur les algorithmes quantiques dits « hybrides ». Ceux-ci tirent parti de la grande efficacité de l’informatique actuelle pour le traitement de certaines sous-routines tout en confiant à un processeur quantique des tâches pour lesquelles ses spécificités lui font jouer un rôle d’accélérateur. Ces algorithmes sont aujourd’hui les seuls pour lesquels des tests empiriques ont été conduits, et dont les performances suggèrent l’existence de l’avantage quantique à moyen terme, qui devrait se manifester a minima pour des machines comptant entre plusieurs centaines et plusieurs milliers de qubits en l’absence de mécanismes de correction des erreurs.

L’arrivée de l’hypothétique suprématie quantique reste toutefois soumise au rythme des progrès de l’ingénierie, confrontée au double défi de l’intégration d’un nombre toujours plus important de qubits et de l’implémentation des codes correcteurs d’erreurs, qui semblent indispensables à l’accroissement recherché de la fiabilité des calculs. L’arrivée des ordinateurs quantiques universels fiables n’est donc pas pour tout de suite.

La finance, historiquement pionnière dans l’adoption des nouvelles technologies numériques, s’emploie depuis pourtant près de vingt ans à préparer leur arrivée. Attentive aux prophéties sur la fin imminente de la loi de Moore, qui a largement contribué à sa croissance par le passé en rendant possible la démocratisation du PC et les simulations numériques, elle a conscience que sa prospérité future est étroitement liée aux progrès de l’informatique fondamentale.

La Finance a la chance d’être en bonne place pour bénéficier de ces avancées. Beaucoup des problèmes qui l’intéressent prennent naturellement la forme de programmes d’optimisation sous contrainte accessibles aux algorithmes quantiques hybrides. Les premières applications ne se sont donc pas fait attendre. De grands noms de l’industrie investissent depuis déjà plus d’une décennie dans la finance quantique avec l’espoir d’être parmi les premiers à tirer profit de son extraordinaire potentiel de transformation.

Ainsi, Goldman Sachs possède des équipes de recherche dédiées en interne et nourrit des collaborations avec les sociétés américaines QC Ware et IonQ, spécialisées respectivement dans la conception d’algorithmes et la construction d’ordinateurs à atomes froids. L’objectif est de tester sur une machine quantique l’accélération de la simulation Monte-Carlo, qui est actuellement l’une des méthodes les plus utilisées pour le pricing de portefeuilles et la détermination de la Value at risk (VaR), la métrique de référence pour l’évaluation des pertes potentielles liées à un investissement sur une période donnée.

De son côté, JP Morgan investit pour se préparer à l’obsolescence programmée de la cryptographie RSA sur laquelle repose actuellement toute la sécurité des transactions par carte bancaire. Ce protocole repose sur l’impossibilité pour les ordinateurs actuels de factoriser de très grands nombres entiers en un temps raisonnable, problème qui serait résolu par l’utilisation sur une machine quantique du célèbre algorithme publié par Peter Shor en 1994. Le secteur bancaire, bien conscient de ce risque, s’est donc engagé dans une véritable course à la cryptographie post-quantique de façon à pouvoir protéger les données des utilisateurs lors de la potentielle intrusion d’un pirate informatique équipé d’un ordinateur quantique. Pour sa part, Citigroup a acheté des parts des sociétés Qc Ware et 1QBit en 2019 et réaffirme régulièrement son intérêt pour cette technologie.

Vers une réorientation de l’offre au profit de la finance

Du côté de l’offre, un modèle semble émerger : un API communicant avec un service Cloud permettant d’exécuter des algorithmes hybrides, simulés soit sur des ordinateurs conventionnels (les solutions dites quantum ready) ou sur le hardware quantique développé par l’entreprise (quantum solutions). Cette idée du Quantum as a Service (QaaS) a initialement été développée à titre expérimental par IBM avec son service IBM Quantum Experience (IBM Q), et a été reprise depuis par les autres géants de l’industrie technologique. Microsoft a noué des partenariats avec les sociétés IonQ, Rigetti, Quantinuum ou encore Pasqal pour commercialiser du temps de calcul sur calculateur quantique via sa plateforme Azure Quantum. Amazon propose une offre similaire avec Amazon Braket, disponible sur son service de Cloud Computing AWS, et Google propose un service équivalent avec Google Quantum AI. Mais à la différence de ses deux concurrents, Google s’est engagé dans la course à la construction du premier ordinateur quantique universel fiable à l’horizon 2029. Ce modèle permet aux entreprises qui développent le hardware de vendre le calcul quantique comme un service en proposant des abonnements en l’échange de temps de calcul sur leurs machines. Ce business model offre de la flexibilité côté client (Cloud et abonnements en fonction des besoins effectifs) tout en évitant les contraintes que supposerait le passage à l’échelle d’une production industrielle.

Parallèlement aux efforts de recherche interne des grandes banques, les propositions commerciales destinées à la finance se sont progressivement développées chez les sociétés de l’écosystème quantique. Pasqal, par exemple, propose une plateforme Cloud dédiée à ses clients ainsi qu’un kit de développement open-source dédié au développement d’applications spécifiquement conçues pour les calculateurs à atomes neutres. La société propose la valorisation des produits dérivés échangés de gré à gré à l’aide de réseaux de neurones accéléré par un processeur quantique, ainsi que la génération de séries temporelles synthétiques à partir des cours observés des marchés à l’aide d’un algorithme d’échantillonnage innovant qui exploite les propriétés surprenantes du monde quantique. La start-up espagnole Multiverse Computing cible explicitement les applications à la finance avec son interface utilisateur directement intégrée aux feuilles de calcul Microsoft Excel. Limitée dans ses performances par l’immaturité de la technologie, cette initiative témoigne néanmoins d’un réel effort de démocratisation du calcul quantique. L’idée est d’œuvrer à le rendre aussi accessible que possible en prévision du temps, encore hypothétique, où il deviendrait indispensable. C’est d’ailleurs la promesse qui a permis à cette jeune société de lever un total de 24 millions d’euros depuis juin 2020 auprès de 16 investisseurs, dont le fond de capital risque européen EIT Digital et le European Innovation Council.

Perspectives

La multiplication observée des flux de capitaux et des partenariats esquisse les contours d’un cercle vertueux entre le monde financier et un écosystème quantique en plein essor. En plus de lui donner accès à des partenaires disposés à lui fournir les moyens de démontrer sa technologie, la finance offre de nombreux cas d’usage et ne cesse d’inspirer la conception de nouveaux algorithmes.

Inversement, soucieuses d’accommoder leur offre aux besoins de leur mécène, les sociétés du quantique ont amorcé un véritable pivot stratégique. Par leurs investissements, les grandes banques sont en position d’accélérer et d’orienter le développement technologique. Cette association favorise d’ores et déjà la recherche, et travaille dans un même mouvement à favoriser l’adoption de cette technologie par l’ensemble du tissu industriel. L’extrême polyvalence de ce nouvel outil est l’assurance que les avancées réalisées ne seront pas utiles aux seuls acteurs du monde de la finance. Dans la continuité de cet indispensable travail de préparation de l’avenir, les institutions financières doivent désormais réorienter une partie de leur effort vers l’identification des activités et services qui bénéficieront un jour de ces avancées.